Un appello di scienziati italiani contro le “armi completamente autonome” riapre la discussione sulla intelligenza artificiale applicata agli armamenti.

Un recente appello di ricercatori italiani di intelligenza artificiale, robotica e informatica e discipline collegate richiede a governo e parlamento la messa al bando delle armi completamente autonome nonché di assumere una decisa posizione contro le armi autonome nei forum diplomatici internazionali. Tale richiesta ravviva i timori e riapre la discussione in merito all’intelligenza artificiale applicata agli armamenti. L’appello dei ricercatori italiani denuncia il pericolo articolandolo in quattro contestazioni: costituisce una grave minaccia per il rispetto delle leggi umanitarie in guerra; può interrompere la catena di comando e controllo, la quale consente di individuare i soggetti responsabili per eventuali crimini di guerra; dà alle macchine la possibilità di decidere della vita o della morte di un essere umano; impedisce alle potenziali vittime di fare appello all’umanità condivisa degli avversari.

Contestazioni certamente opportune e pienamente condivisibili, anche se – considerando che tra i promotori c'è per esempio Rete italiana per il disarmo – hanno forse uno scopo ultimo differente. Iniziative di questo genere non sono nuove o uniche, anche le Nazioni unite monitorano con attenzione la situazione e, dal 2016, esiste un gruppo di “Esperti governativi sui sistemi letali di armi autonome”: durante un convegno da questo organizzato lo scorso anno, però, Russia, Israele e Stati Uniti si sono pronunciati a sfavore di un eventuale bando internazionale contro lo sviluppo di queste tecnologie. Esistono anche campagne di sensibilizzazione internazionali come “Stop killer robot” (stopkillerrobots.org).

Il Dipartimento della difesa americano, tuttavia, sollecitato dalle polemiche di una sua recente richiesta per un “Advanced targeting & lethality automated system” (Sistema avanzato automatico di designazione e letalità) da installarsi sui mezzi corazzati, ha specificato che : “Tutti gli sviluppi e impieghi di funzioni semi autonome o autonome nei sistemi d’arma, incluse le piattaforme pilotate e a controllo remoto, restano soggette alle linee guida del Dipartimento della difesa della Direttiva 3000.09 aggiornata nel 2017”.

Che cosa dice tale direttiva? Richiede che gli operatori militari debbano essere in grado di esercitare appropriati livelli di giudizio “umano” nell’uso della forza, significando che gli Stati Uniti non intendono immettere sul campo di battaglia un “robot” completamente autonomo che possa decidere indipendentemente di uccidere qualcuno. La salvaguardia è il processo comunemente conosciuto come “man in the loop” ossia che ci sia un “uomo” nel processo decisionale per l’impiego di una arma. Che è quello che avviene già per esempio nel caso dei cosiddetti “droni killer” o meglio, droni armati: hanno caratteristiche più o meno autonome nel senso di alcune modalità di volo “automatiche”, ma è l’operatore umano a terra che identifica il bersaglio e, in ultima analisi e attraverso una serie di procedure e autorizzazioni, lancia il missile sul bersaglio.

Ma quale è attualmente lo stato dell’arte in merito all’intelligenza artificiale negli armamenti? Innanzitutto, non vi sono al momento armi che abbiano la piena ed autonoma capacità di uccidere da sole, non risultano neanche studi futuri in merito ad armi “completamente autonome”: e questo anche per il rischio che una intelligenza in “avaria”, possa sparare alle forze amiche indiscriminatamente.

Quali sono i vantaggi dell’impiego dell’intelligenza artificiale in ambito militare e perché alcuni Paesi non sono affatto contrari al suo sviluppo? Perché l’intelligenza artificiale può anche salvare vite umane e quelle delle cosiddette vittime collaterali, i civili. L’intelligenza artificiale viene considerata si, una opportunità per migliorare la letalità, ma anche uno strumento per salvaguardare da false attribuzioni di pericolo i militari sotto stress, da una situazione o un bersaglio che in realtà non sono una minaccia. L’intelligenza artificiale prima di designare un bersaglio, lo identifica positivamente, applicando strettamente molti più parametri discriminativi e più velocemente di quanto possa fare un militare in combattimento sotto stress. Che potrebbe scordarsene qualcuno. Come già successo e con gravi risultati in passato: vedasi il caso del jet civile iraniano Volo 655, abbattuto dall’incrociatore Uss Vincennes sopra lo stretto di Hormuz il 3 luglio 1988, scambiato per un F14 iraniano in attacco anti nave.

In questo caso, probabilmente, l’intelligenza artificiale avrebbe potuto evitare la strage grazie alla capacità di osservare strettamente tutta una serie di procedure e verifiche sul potenziale bersaglio prima di definirlo una minaccia, in modo più articolato e veloce, rispetto la mente umana e soprattutto, rispetto una mente stressata dalla situazione: l’incrociatore americano, in effetti, stava manovrando in combattimento quando apparve improvvisamente sugli schermi radar l’aereo di linea e il comandante temendo un attacco missilistico dall’aria, dovette prendere una decisione in pochi secondi, sbagliando.

L’intelligenza artificiale può aiutare il combattente in molti casi: nei carri pilotati potrebbe diventare un osservatore e designatore di bersagli autonomo più pronto e attento e quindi, più “letale”, ma chi spara è sempre un umano e può verificare che il “bersaglio” sia una reale minaccia. Lo stesso ruolo di “designazione” e non distruzione, potrebbe essere comunque inserito anche in un mezzo autonomo o Ugv-Unmanned ground vehicle come negli Uav-Unmanned aerial vehicle.

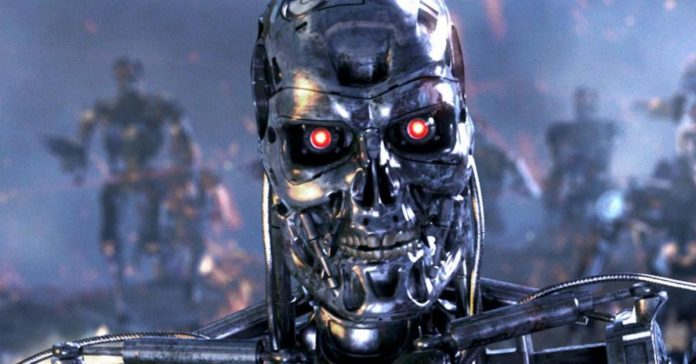

Dove si fa ancora confusione è sul termine “autonomo”, che indica sì una certa autonomia nella condotta del mezzo (drone terrestre, navale o aereo che sia), ma non ancora e si spera mai, una completa autonomia decisionale. Siamo ancora lontani da Skynet!